Digital

comment calculer la moyenne en Python : guide et exemples pratiques

calcul moyenne Python : bases fiables avec sum() et len()

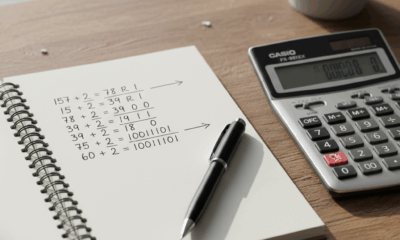

Le calcul d’une moyenne arithmétique Python repose d’abord sur une paire d’outils intégrés et fiables : sum() et len(). Cette combinaison incarne le cœur d’un tutoriel moyenne Python sérieux, car elle couvre 80 % des besoins métiers. L’idée est simple : additionner les éléments numériques d’une séquence, puis diviser par la taille de cette séquence. Par exemple, avec une liste de notes ou de durées de réponse d’API, le code Python moyenne minimal reste la formule moyenne = sum(donnees) / len(donnees). Ce guide calcul moyenne commence par ces fondations pour ancrer des automatismes robustes et faciles à relire en 2025.

Le réflexe essentiel consiste à s’assurer que la séquence n’est pas vide et que ses éléments sont numériques. Lorsqu’une application manipule des listes issues de CSV, de JSON ou d’une base de données, un programme calcul moyenne doit refuser poliment les types non attendus et les listes vides. Sans ces précautions, la division par zéro ou les erreurs de type peuvent interrompre un pipeline d’analyse. Pour des étudiants, des data analysts ou des développeurs backend, l’approche pragmatique est la même : sécuriser les données d’entrée, puis calculer.

Exemple de base : liste = [10, 20, 30] puis moyenne = sum(liste) / len(liste). L’expression est si courante qu’elle redevient presque une “signature” d’un exemple moyenne Python lisible. En auditant des scripts hérités, retrouver cette ligne renseigne sur la clarté du projet. On peut d’ailleurs croiser cette logique dans des tutoriels ludiques, comme un mini-jeu ou un simulateur : élargir la pratique avec un projet Pong en Python permet d’exercer les boucles, les listes et la gestion d’entrées, des bases utiles au calcul moyenne Python.

Patrons de code essentiels pour débuter et éviter les pièges

Pourquoi autant d’insistance sur la validation des entrées ? Parce que les sources de données réelles sont rarement “propres”. Les flux contiennent parfois des None, des chaînes vides ou des décimales au format chaîne. Avant d’appliquer sum(), mieux vaut transformer ou filtrer. Un filtre simple : valides = [x for x in donnees si isinstance(x, (int, float))]. Puis moyenne = sum(valides) / len(valides), après vérification de la longueur. Ce pattern s’intègre sans friction dans un tutoriel moyenne Python et devient un réflexe de production.

- ✅ Vérifier la longueur de la liste avant division 🧮

- 🧰 Filtrer les types non numériques pour fiabiliser la fonction moyenne Python 🔎

- 🧪 Tester des cas limites (liste vide, only floats, valeurs très grandes) 🧯

- 🧭 Documenter l’intention pour faciliter la maintenance du programme calcul moyenne 📚

Le vocabulaire joue un rôle SEO utile : “moyenne liste Python”, “calcul statistique Python” ou “moyenne arithmétique Python” aident les lecteurs à trouver les bonnes réponses. Mais la lisibilité du code garde la priorité. En contexte pédagogique, l’entraînement sur des structures de listes renforce les acquis ; un exemple complémentaire est la manipulation d’un tableau Bataille navale en Python, qui oblige à parcourir des tableaux, à filtrer et à agréger, autant de gestes réutilisables pour calculer des moyennes.

| Cas d’usage 🔎 | Approche conseillée 🧭 | Exemple de code ✍️ | Point clé 💡 |

|---|---|---|---|

| Liste simple d’entiers | sum() + len() | m = sum(L) / len(L) | Suffisant pour un exemple moyenne Python |

| Présence de None | Filtrer les None | valides = [x for x in L si x is not None] | Éviter la casse à l’exécution 🚫 |

| Types mélangés | Filtrer int/float | valides = [x for x in L si isinstance(x, (int, float))] | La fonction moyenne Python reste stable |

| Petit volume | Rester en pur Python | sum/len | Lisible, rapide à coder ⏱️ |

Pour consolider ces notions avec une autre perspective d’itération, les lecteurs peuvent comparer les techniques pour parcourir un tableau en JavaScript : la logique de base se transpose et renforce l’intuition pour le calcul moyenne Python. Insight final : les fondations sum/len restent la référence, à condition d’ajouter des garde-fous de validation.

La mise en pratique vidéo montre le cycle complet : lecture, filtrage, calcul, tests.

moyenne liste Python en production : validations et robustesse

Quand une équipe opère un service numérique, la moyenne liste Python sert souvent à des métriques critiques : temps de réponse, prix moyens, consommation de ressources. Un pipeline non protégé peut tomber sur une liste vide venue d’une fenêtre de collecte, ou sur un type inattendu (par exemple “42” au lieu de 42). Le remède est systématique : contrôler l’entrée, normaliser, puis calculer. Cette démarche renforce la fiabilité d’un programme calcul moyenne et facilite le débogage.

Le cas pratique le plus fréquent : des None parsèment les données. Deux stratégies coexistent. Exclure les None : cela revient à calculer la moyenne des valeurs observées, en ignorant les manquants. Ou imputer une valeur (moyenne précédente, médiane) si la logique métier l’exige. Sans directive claire, mieux vaut documenter la décision pour garder la confiance dans la mesure. Cette discipline s’applique autant à un tableau de capteurs qu’à un flux e-commerce.

Checklist anti-bug pour le calcul de moyenne arithmétique Python

Une base réutilisable : transformer la validation en fonctions utilitaires ou en classe. Les scripts gagnent en lisibilité et les tests deviennent normés. En parlant de tests, même un projet d’apprentissage — par exemple un jeu du plus ou moins — peut servir à éprouver la robustesse des conversions de types et des conditions de sortie. Une fois les fondations solides, les calculs statistiques tiennent la charge.

- 🧩 Contrôle de longueur : si len(L) == 0, lever une exception explicite ⚠️

- 🧼 Nettoyage des types : n’autoriser que int et float 🧽

- 🧯 Gestion des None : exclure, remplacer ou consigner l’événement 🗒️

- 🛠️ Traiter les valeurs aberrantes selon une règle métier claire 📏

- 📈 Journaliser les décisions pour l’audit et la traçabilité 🧾

Lorsqu’il faut fournir des données de test, il est pratique de générer des nombres aléatoires en Python pour simuler volumes et distributions. La variété des scénarios mettra à jour des faiblesses cachées : conversions implicites, division par zéro, ou arrondis trompeurs. En parallèle, le code doit rester concis pour être compris en une lecture.

| Validation 🔍 | Pourquoi 🧠 | Exemple ✍️ | Résultat ✅ |

|---|---|---|---|

| Longueur non nulle | Éviter division par zéro | if not L: raise ValueError | Pipeline stable 🧱 |

| Types numériques | sum() exige nombres | L = [x for x in L si isinstance(x, (int, float))] | Calcul fiable 🔒 |

| Filtrer None | None casse sum() | L = [x for x in L si x is not None] | Moins d’erreurs 🚀 |

| Outliers | Limiter l’influence | L = [x for x in L si x < seuil] | Métrique pertinente 🎯 |

En formation, des exercices autour de structures 2D (grilles) — par exemple coder une Bataille navale — aident à raisonner sur des index, des boucles et des conditions. Ces savoir-faire se transposent directement dans le calcul statistique Python, notamment pour agréger des séries chronologiques. Insight final : la robustesse, c’est la validation d’entrée plus la documentation de ce qui est exclu ou ajusté.

Du code Python moyenne à la variance et à la moyenne pondérée

Une fois la moyenne simple maîtrisée, les équipes étendent le cadre : moyennes pondérées, variance, écart-type, voire transformations comme la racine carrée. Le passage de la moyenne à la variance enrichit l’analyse en révélant la dispersion. En contexte opérationnel, cela sert à calibrer des alertes : deux ensembles peuvent partager la même moyenne mais diverger fortement dans l’étendue des valeurs. Voilà pourquoi un guide calcul moyenne crédible inclut la variance, côté population et côté échantillon.

Illustration lisible en pur Python. Calculer d’abord la moyenne : m = sum(L) / len(L). Puis la variance population : var = sum((x – m) ** 2 for x in L) / len(L). Pour la variance d’échantillon, utiliser le dénominateur (n – 1). Ces étapes suivent un enchaînement clair, adapté à un tutoriel moyenne Python qui veut aussi initier à la dispersion. On peut également composer des opérations : appliquer une transformation (par exemple la racine carrée via math.sqrt) avant d’agréger.

NumPy, Pandas et calculs pondérés : quand basculer ?

Quand les volumes grimpent à des millions de points, NumPy devient l’outil principal grâce à la vectorisation en C. np.mean, np.var et np.average (avec weights) accélèrent les traitements et simplifient le code. Pandas, qui s’appuie sur NumPy, apporte des méthodes .mean() et .var() pratiques pour les séries temporelles et les DataFrames. En 2025, ces bibliothèques constituent le socle industriel de l’analytics en Python.

- 📦 Pure Python pour petits jeux de données et scripts utilitaires 🧰

- ⚡ NumPy pour vecteurs massifs, calculs batch et pipelines ML 🚀

- 🗂️ Pandas pour séries chronologiques et jointures de colonnes 📊

- 🎯 Moyenne pondérée avec np.average(weights=…) pour refléter l’importance relative ⚖️

Pour s’exercer sur des boucles et conditionnels avant d’attaquer les statistiques, un détour par la logique de la grille et des interactions peut aider. Par exemple, des mécaniques de jeu renforcent la rigueur des structures de contrôle ; un rappel utile est de savoir générer des séries de test, comme dans le cas des nombres pseudo-aléatoires, ou même d’explorer comment afficher du texte avec Pygame pour visualiser des moyennes en direct lors d’une simulation.

| Méthode 🧮 | Forces 💪 | Quand l’utiliser ⏱️ | Exemple 👀 |

|---|---|---|---|

| sum()/len() | Lisible, zéro dépendance | Petits volumes | code Python moyenne minimal ✅ |

| NumPy mean/var | Très rapide, vectorisé | Millions d’éléments | np.mean(arr), np.var(arr) ⚡ |

| Pandas mean/var | API riche sur colonnes | DataFrames | df[« x »].mean(), df[« x »].var() 📈 |

| Moyenne pondérée | Poids explicites | Échantillons hétérogènes | np.average(x, weights=w) ⚖️ |

Cette montée en puissance s’inscrit dans une progression pédagogique : des bases pures Python vers des outils spécialisés. Insight final : choisir l’outil pour sa lisibilité et son adéquation métier avant de viser l’optimisation micro.

La démonstration vidéo clarifie la différence entre variance population et échantillon (ddof=1).

programme calcul moyenne pour monitoring d’API : étude de cas DataPulse

Pour illustrer la mise en œuvre, prenons un pipeline de monitoring. L’équipe fictive DataPulse collecte les temps de réponse d’une API, calcule régulièrement la moyenne et la variance, puis déclenche une alerte si des seuils sont franchis. La mécanique s’applique à des webhooks, des capteurs IoT ou des jobs batch. Avec une politique claire de traitement des valeurs manquantes et aberrantes, la moyenne liste Python devient une mesure de santé opérationnelle.

Le cycle type : ingestion, nettoyage, agrégation, exposition. À l’ingestion, les durées brutes arrivent sous forme de liste : [120, 95, 100, None, 300]. Le nettoyage filtre les None et les valeurs absurdes (par exemple supérieures à 10 000 ms). L’agrégation calcule sum()/len() pour la moyenne et la variance associée. L’exposition renvoie la métrique à un dashboard, un journal ou une alerte Slack. Cette architecture minimaliste illustre un calcul statistique Python utile et durable.

Nettoyage, agrégation et alerte : logique pas à pas

La logique métier détermine les seuils : un 95e centile peut coexister avec la moyenne pour éviter d’être aveuglé par la dispersion. Si un front-end temps réel doit afficher le résultat, un module d’affichage peut s’en charger ; utile notamment pour des prototypes où l’on souhaite afficher rapidement du texte avec Pygame et itérer sur le design des indicateurs. Pour des tableaux de bord web, apprendre à créer une page web moderne aide à diffuser ces métriques à l’équipe.

- 📥 Ingestion : récupérer une liste de durées (ms) depuis les logs 🔌

- 🧼 Prétraitement : filtrer None et outliers selon la règle métier 🧽

- 🧮 Agrégation : calculer moyenne = sum(valides) / len(valides) 🧠

- 🚨 Déclenchement : comparer à un seuil, ouvrir une alerte si besoin 📣

- 📊 Exposition : envoyer vers dashboard, logs ou API d’observabilité 🛰️

Des datasets de test se génèrent avec des distributions variées : uniformes ou gaussiennes, pour éprouver la sensibilité de la moyenne aux outliers. Les développeurs qui aiment apprendre par le jeu peuvent réinvestir des techniques vues dans des projets ludiques. À titre d’inspiration, manipuler des entrées/sorties comme dans un tutoriel Pong ou des grilles comme dans un exercice Bataille navale renforce l’aisance sur les listes et la logique conditionnelle.

| Étape 🧭 | Entrée 🔌 | Traitement ⚙️ | Sortie 📤 | Alerte 🚨 |

|---|---|---|---|---|

| Ingestion | Liste de durées | Validation type/None | Liste filtrée | — |

| Agrégation | Liste filtrée | sum()/len(), variance | Moyenne, variance | Seuil comparé ✅ |

| Exposition | Métriques | Format JSON | Dashboard/API | Slack/Email si seuil |

| Post-traitement | Historique | Lissage/rolling | Tendance | Tolérance ajustée 🎯 |

Insight final : consigner la politique de filtrage et d’alerte. Sans cela, une moyenne “qui bouge” perd sa crédibilité auprès des équipes produits et support.

Performance, NumPy et documentation : guide calcul moyenne durable

La performance s’évalue avant de s’optimiser. Pour des volumes modestes, sum() et len() sont excellents : pas de dépendances, code lisible, et latence négligeable. Au-delà de quelques millions d’éléments ou dans des boucles intensives, la bascule vers NumPy s’impose grâce à la vectorisation. Le choix dépend de contraintes CPU/mémoire et de la fréquence de calcul. Inutile de complexifier prématurément ; la simplicité gagne tant que le SLA est respecté.

La documentation joue un rôle tout aussi crucial. Décrire la fonction, ses paramètres, les valeurs invalides et les exemples d’usage améliore la maintenance. Un chapitre “comportement face aux None, chaînes, listes vides” évite les malentendus. Inclure des tests unitaires et d’intégration consolide la confiance. Pour des modules réutilisables, la mise à disposition d’exemples concrets sert autant à l’onboarding qu’au support.

Bonnes pratiques pour outiller, profiler et expliquer

Un développeur peut démarrer en pur Python, mesurer, puis décider d’adopter NumPy si les temps explosent. Profiler la mémoire et le CPU sur des jeux de données représentatifs reste déterminant. Côté veille et culture technique, explorer des exercices de manipulation numérique aide à perfectionner l’intuition ; par exemple, s’entraîner autour des séries pseudo-aléatoires via Java pour comparer les approches, ou revoir des principes d’itération élémentaires dans des jeux pédagogiques.

- 🧪 Écrire des tests pour tous les cas limites et valeurs aberrantes ✅

- 📏 Documenter le comportement avec None, chaînes et listes vides 🧾

- ⚡ Passer à NumPy quand la taille explose (vectorisation) 🚀

- 🧭 Expliquer la logique métier dans les docstrings et le README 📚

- 🔗 Ajouter des liens internes pour la veille : exercices, tutos, et projets 🧠

Cette approche s’inscrit dans une pédagogie progressive : partir d’un code Python moyenne minimal, ajouter la robustesse, étendre aux statistiques, documenter et outiller. Des ressources complémentaires — comme apprendre le Morse pour réfléchir aux encodages, ou revisiter des structures logiques avec des mini-projets — entretiennent une curiosité utile dans un écosystème en évolution.

| Volume de données 📦 | Outil recommandé 🧰 | Avantage principal 💡 | Note pratique 🗒️ |

|---|---|---|---|

| Petit (≤ 100k) | sum()/len() | Simplicité, zéro dépendance | Priorité à la lisibilité ✅ |

| Moyen (≈ 100k–5M) | NumPy | Vectorisation rapide | Mesurer avant d’optimiser ⚖️ |

| Grand (≥ 5M) | NumPy + chunking | Optimisé C/BLAS | Éviter les copies mémoire 🧠 |

| Tabulaire | Pandas | Colonnes et index | API .mean()/.var() 📊 |

Pour enrichir la pratique, des projets applicatifs restent précieux : manipuler des listes, des grilles, des entrées utilisateur. Un entraînement transversal peut passer par des tutoriels comme un jeu du plus ou moins ou des ateliers “parcours d’indices”. Insight final : performance et documentation forment un duo indissociable pour ancrer des métriques durables.

Structurer un module testable : classe utilitaire et choix des bibliothèques

Au-delà des scripts, une équipe gagne à encapsuler le calcul dans un module ou une classe. Le constructeur valide les entrées, les méthodes exposent les calculs unitaires (moyenne, variance, moyenne pondérée), et les tests couvrent cas normal, list vide, types mélangés et performances. Cette structuration rend le composant “plug-and-play” dans un microservice, un ETL ou une application analytique.

Un design minimal : une classe avec __init__ qui refuse les entrées invalides, calculer_moyenne, calculer_variance, calculer_moyenne_ponderee. Dans un service orienté API, une méthode to_dict renvoie les métriques sérialisées pour intégration dans un dashboard. Les choix techniques suivent la règle du moindre effort : pur Python pour le petit volume, NumPy quand la charge grandit.

Design d’API interne, logs et tests continus

Documenter l’interface publique du module accélère la diffusion interne. Les logs doivent consigner les décisions (éléments exclus, seuils appliqués) sans saturer l’observabilité. Les tests CI exécutent un corpus d’exemples et des benchmarks simples pour repérer une régression de performance. Le résultat final : un programme calcul moyenne prédictible, lisible et pérenne.

- 🏗️ Classe dédiée : petites méthodes, responsabilités claires 🧩

- 🧰 Fonctions pures : faciles à tester et à réutiliser ✅

- 🧮 Option NumPy derrière un flag pour les gros volumes ⚙️

- 📦 Sérialisation des sorties (JSON) pour l’intégration 🛰️

- 🧪 Benchmarks légers dans la CI pour surveiller le temps d’exécution ⏱️

Un atelier concret peut articuler statistiques et logique algorithmique. À titre d’inspiration ludique, revisiter des mécaniques de grilles et de parcours renforce les compétences de base ; des ressources comme des guides d’itération ou des générateurs de données sont utiles sur le long terme. Pour prolonger l’exploration front, explorer les fondamentaux de l’édition web avec un guide pour créer une page web en 2025 permettra d’exposer la moyenne et la variance dans un tableau responsive.

| Composant 🔧 | Rôle 🎯 | Bénéfice 💡 | Astuce ✨ |

|---|---|---|---|

| Constructeur | Valider l’entrée | Moins d’exceptions | Refuser list vide ✅ |

| calculer_moyenne | sum()/len() | Rapide, clair | Filtrer None d’abord 🧼 |

| calculer_variance | Dispersion | Alerte pertinente | Choisir n vs n-1 📏 |

| calculer_moyenne_ponderee | Poids | Mesure fidèle | np.average si lourd ⚖️ |

Insight final : structurer le module, c’est accélérer la relecture de code et fiabiliser la mise en production des métriques.

Quelle est la façon la plus simple de calculer une moyenne en Python ?

Utiliser sum() et len() : moyenne = sum(liste) / len(liste). Vérifier que la liste n’est pas vide et que les éléments sont numériques pour éviter les erreurs.

Comment gérer None ou des types mélangés dans une liste ?

Filtrer les entrées : valides = [x for x in liste si isinstance(x, (int, float))]. Exclure les None, puis calculer ; documenter la politique de filtrage.

Quand passer à NumPy pour la moyenne et la variance ?

Dès que le volume approche les millions d’éléments ou que les calculs sont intensifs. NumPy vectorise et accélère mean/var/average. Pour de petits ensembles, sum()+len() suffit.

Comment écrire un module réutilisable pour le calcul de moyenne ?

Encapsuler dans une classe avec validation d’entrée, méthodes dédiées (moyenne, variance, moyenne pondérée), tests unitaires, logs et documentation du comportement face aux entrées invalides.

La moyenne doit-elle être accompagnée d’autres métriques ?

Oui. Associer la moyenne à la variance, à l’écart-type, et parfois aux percentiles pour éviter les conclusions biaisées par des valeurs extrêmes.

Nathan explore sans relâche les avancées de l’intelligence artificielle et leurs impacts sociétaux. Il adore vulgariser les concepts complexes, avec un ton engageant et des métaphores qui parlent à tous les curieux du numérique.

DataPulse Analyst

2 décembre 2025 at 10h32

Les précautions suggérées garantissent la stabilité des calculs.

Zephyr Quillon

2 décembre 2025 at 13h44

Article utile, facile à lire. Merci pour ce guide pratique sur Python !

Zypher Quillon

2 décembre 2025 at 17h32

Super article, très utile pour débuter avec Python facilement !

Zypher Orion

2 décembre 2025 at 17h32

Article clair et utile pour comprendre le calcul de moyenne en Python.

Zéphyr Antolin

2 décembre 2025 at 17h32

Guide pratique pour calculer facilement des moyennes en Python.

Zylanth Ternelis

2 décembre 2025 at 20h04

Ce guide sur la moyenne en Python est vraiment utile et clair.

Zéphyrin Célestiel

2 décembre 2025 at 20h04

Article utile pour maîtriser le calcul des moyennes en Python. Merci !